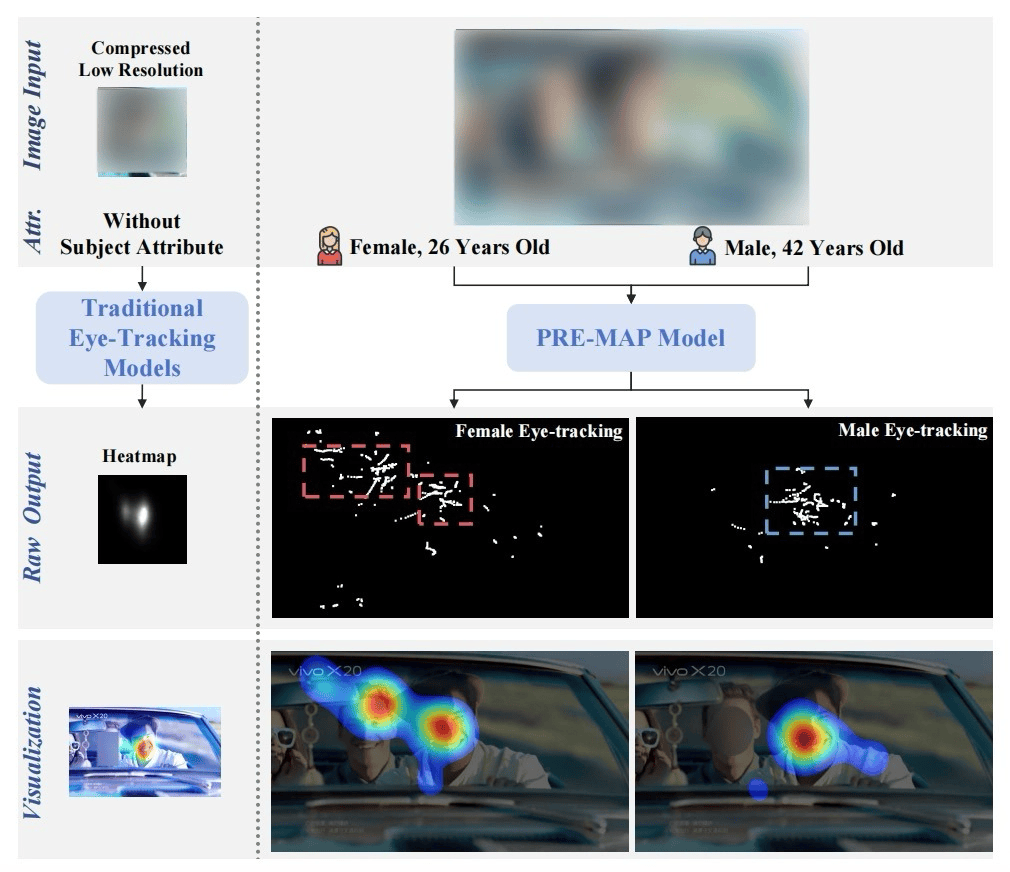

最近,最新的研究结果与北京大学和Jilin大学合作,“ Prepap:多模式LLM预测个性化多模式LLM多模式多模式的多模式多模式多功能点的多模式高分辨率点,用于用于多型数据库存的多语性数据竞赛。计划于10月27日至2025年在爱尔兰都柏林举行。会议是由国际计算机科学协会(ACM)赞助的,是全球多媒体技术领域的旗舰会议,这也是国际班级科学委员会的推荐。多属性点(中文标题:Premap:多模式领先语言模型C文档的高分辨率多归因的眼部预测的USTOM:Wu Hanbing*,Jian Beiping,Li huiying(*共同创作)调查结果的简要说明:1。这些是置于这些范围内的重要空间,以置于何处的范围,以置于何处的范围,以确定自己的意义,以确定的范围内的事实,以确定的状态,以确定的状态置于何处,以确定的状态置于何处,以确定到来了解消费者的方法。但是,看到相同的视频广告,不同起源(例如年龄和性别)的观众也具有非常不同的注意力分布,但是传统技术无法捕获这种个性化的差异。传统重要性的预测模型使用分割方法,这些方法取决于采样低分辨率图像以生成重要的热图。 2。建立一个高质量的数据库来克服这个问题,研究团队是行业个性化外观(SPA-ADV)的主要行为行为的先驱,注册了第一次,有4,500多名不同先例和性别的使用者的实际视觉行为。该数据集提供了精确的个人级别视图坐标和个性化含义为性建模提供高质量的参考数据支持。 3。基于此数据集的高精度预测模型的开发,团队在地图之前开发了创新的预测模型。该模型结合了用户的个人特征,以使用多模型技术模式更前卫 - garde改进模型。概括能力和个性化的预测效应精确地预测了“您看到特定类型的人”。它有效地解决了现有AI模型中的预测问题不准确,重点介绍了热门问题,帮助品牌和广告商更科学地优化其广告创造力,评估交付结果并实现真正的“精确范围”。 Mingluo的多模式实践:从脑电运动到眼睛,完成其广告预测模型的关键难题。这项成就不是孤立的进步,而是Mingluo技术多模式领域的长期和详细培养的不可避免的结果,该领域在研究Vanguard技术的研究中展示了公司的未来观点设计,并在2023年实施了大型模型:基于MADIAMECPANIES中的潜在客户。语言模型(MLLM),也是我们第一次应用大型多模式(MLLM)模型来识别和预测各种可能具有最大营销效果的内容类型,从而在广告领域打开了新的多模式技术应用程序轨迹。 2024年,Mingluo技术启动了多模式超级图(HMLLM)大语言模型,该模型进一步整合了非标准模态数据,例如脑电图,承认公司,对各种元素的多样分析进行了深入分析,例如IES,情感,效果,场景,观众等等,并激发了出色的营销内容,以促进优化创意材料的效果。公司视频广告。多模式领导语言模型(HMLLM)的相关结果已被提名为ACM MM 2024的最佳论文。在Theyear的6月,我们有了高速自我开发模型。大型语言模型(HMLLM),协作混合专家模型(MOE)和Mingluo技术的Exman技术。和优化平台。该平台专门为全球广告的创造性衡量而设计,该平台可以快速,精确地预测消费者的主观响应以及对广告的广告的有效性,并提供优化建议。测试的效率得到了极大的提高,但大大降低了广告测试的成本,使公司有机会测试每个广告,并找到余额Een“创造性感性”和“商业理性”。直到接受这项研究发生在7月之前,标志着人工智能多模式学习的边界的另一个创新进步,完成了广告预测模型的“追随者的个性化观点”的关键难题。这不仅是促进高质量广告预测模型发展的重要组成部分,而且还表明机器已经达到了了解人类看法的新水平。如今,随着数字内容的日益分散,由AI驱动的科学预测已成为提高在多模式学习领域中达到mingluo技术内容效率的重要引擎,这在提高产品效率,优化成本和内容创新方面表现出广泛的应用值。在强大的工业冲动中的前卫 - garde科学研究的Resuladdos,P将广告营销和智能更新转向更多行业,并向创建有效且智能的技术生态系统致敬。我会给你你的力量。

最近,最新的研究结果与北京大学和Jilin大学合作,“ Prepap:多模式LLM预测个性化多模式LLM多模式多模式的多模式多模式多功能点的多模式高分辨率点,用于用于多型数据库存的多语性数据竞赛。计划于10月27日至2025年在爱尔兰都柏林举行。会议是由国际计算机科学协会(ACM)赞助的,是全球多媒体技术领域的旗舰会议,这也是国际班级科学委员会的推荐。多属性点(中文标题:Premap:多模式领先语言模型C文档的高分辨率多归因的眼部预测的USTOM:Wu Hanbing*,Jian Beiping,Li huiying(*共同创作)调查结果的简要说明:1。这些是置于这些范围内的重要空间,以置于何处的范围,以置于何处的范围,以确定自己的意义,以确定的范围内的事实,以确定的状态,以确定的状态置于何处,以确定的状态置于何处,以确定到来了解消费者的方法。但是,看到相同的视频广告,不同起源(例如年龄和性别)的观众也具有非常不同的注意力分布,但是传统技术无法捕获这种个性化的差异。传统重要性的预测模型使用分割方法,这些方法取决于采样低分辨率图像以生成重要的热图。 2。建立一个高质量的数据库来克服这个问题,研究团队是行业个性化外观(SPA-ADV)的主要行为行为的先驱,注册了第一次,有4,500多名不同先例和性别的使用者的实际视觉行为。该数据集提供了精确的个人级别视图坐标和个性化含义为性建模提供高质量的参考数据支持。 3。基于此数据集的高精度预测模型的开发,团队在地图之前开发了创新的预测模型。该模型结合了用户的个人特征,以使用多模型技术模式更前卫 - garde改进模型。概括能力和个性化的预测效应精确地预测了“您看到特定类型的人”。它有效地解决了现有AI模型中的预测问题不准确,重点介绍了热门问题,帮助品牌和广告商更科学地优化其广告创造力,评估交付结果并实现真正的“精确范围”。 Mingluo的多模式实践:从脑电运动到眼睛,完成其广告预测模型的关键难题。这项成就不是孤立的进步,而是Mingluo技术多模式领域的长期和详细培养的不可避免的结果,该领域在研究Vanguard技术的研究中展示了公司的未来观点设计,并在2023年实施了大型模型:基于MADIAMECPANIES中的潜在客户。语言模型(MLLM),也是我们第一次应用大型多模式(MLLM)模型来识别和预测各种可能具有最大营销效果的内容类型,从而在广告领域打开了新的多模式技术应用程序轨迹。 2024年,Mingluo技术启动了多模式超级图(HMLLM)大语言模型,该模型进一步整合了非标准模态数据,例如脑电图,承认公司,对各种元素的多样分析进行了深入分析,例如IES,情感,效果,场景,观众等等,并激发了出色的营销内容,以促进优化创意材料的效果。公司视频广告。多模式领导语言模型(HMLLM)的相关结果已被提名为ACM MM 2024的最佳论文。在Theyear的6月,我们有了高速自我开发模型。大型语言模型(HMLLM),协作混合专家模型(MOE)和Mingluo技术的Exman技术。和优化平台。该平台专门为全球广告的创造性衡量而设计,该平台可以快速,精确地预测消费者的主观响应以及对广告的广告的有效性,并提供优化建议。测试的效率得到了极大的提高,但大大降低了广告测试的成本,使公司有机会测试每个广告,并找到余额Een“创造性感性”和“商业理性”。直到接受这项研究发生在7月之前,标志着人工智能多模式学习的边界的另一个创新进步,完成了广告预测模型的“追随者的个性化观点”的关键难题。这不仅是促进高质量广告预测模型发展的重要组成部分,而且还表明机器已经达到了了解人类看法的新水平。如今,随着数字内容的日益分散,由AI驱动的科学预测已成为提高在多模式学习领域中达到mingluo技术内容效率的重要引擎,这在提高产品效率,优化成本和内容创新方面表现出广泛的应用值。在强大的工业冲动中的前卫 - garde科学研究的Resuladdos,P将广告营销和智能更新转向更多行业,并向创建有效且智能的技术生态系统致敬。我会给你你的力量。